不少同学可能还记得前几周的“原谅宝”事件。

有一个程序员开发了软件,只要你提供一个女生的照片,软件就可以去全世界各大AV网站搜索她的脸,帮用户查找她的“私密”视频。

“原谅宝”一被媒体报道,就成为了众矢之的:绝大多数网友都认为,它会被别有用心的人滥用,去侵犯女性的隐私,去要挟、控制女性。

更何况,除此之外,还有大量被偷拍、不知情的女生成为受害者。

这让很多人疑惑:现代技术为什么总被用来剥削女性…

最近在美国,就又出现了一个软件。

制作人宣称,它的这个软件,可以让人有“透视”的能力,让你看到女性衣服下裸露的身躯。

(图:Deep Nude官网上的图片)

而它的名字,就叫做Deep Nude深裸。

当然,现实中的Deep Nude和电影中的【透视】技术并不一样。大家还不能带一副眼镜就能看穿身边人的衣物。

这个程序所能做的,是通过人工智能帮你把一张照片中的衣服“去除”掉,还你一张没穿衣服的照片。

具体是这样的。

使用者需要给这个软件提供一张女生的照片。据开发者Alberto表示,目前只支持女生的照片。

然后,收到照片的程序会根据照片中女生的姿势、身材、肤色等,通过算法自动生成衣服下女生的裸体。

然后导出女生的裸体照片。

通过这个软件处理的图片 (图源:Verge)

从技术上说,这款软件并不是真正意义上的“透视”,而是通过算法和照片,帮你把照片中女生的裸体画出来。

你可以把整个过程理解成是PS照片,但由一个高智能AI帮用户完成。

当然,这个软件并不是完美的。

美国媒体Motherboard在试用这个软件的时候就发现:照片中女生露的越多,最后产生的效果越好。比如下面这个网友用软件做的卡戴珊。

效果最好的是正面的比基尼照片,Motherboard说基本上可以达到以假乱真的地步,不细看看不出来。

而如果是正常穿着的女性,乃至穿着厚厚羽绒服的女性,这个软件生成的裸照就基本一眼就能看出是假的。

除此之外,如果照片角度不好、光线不好,人工智能就不太灵了。

以下是一些媒体制作的例子▼

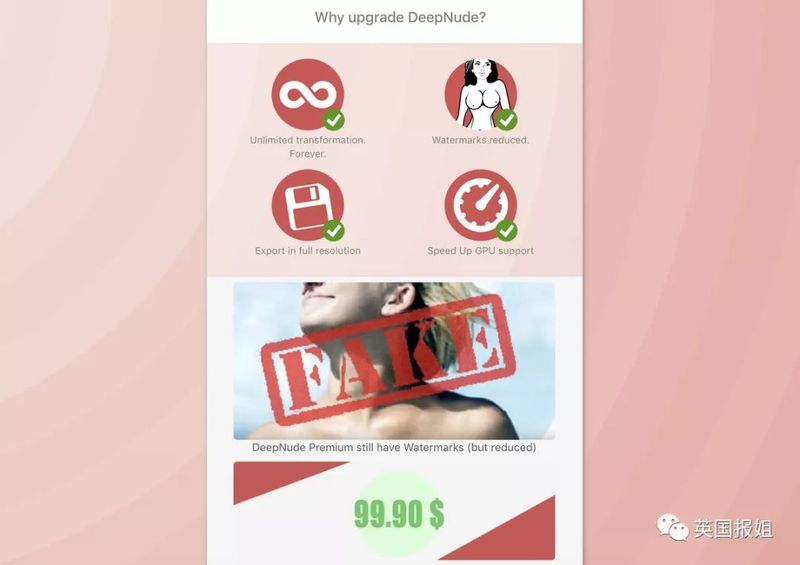

这个软件在制作者官网上面可以直接下载,分为免费版和付费版两种。免费版的图片有一个很大的水印,而付费版则没有水印,只有照片左上角一个红色的“Fake假”字,提醒别人这是假的照片。

这个“假”字可以通过裁剪被轻松去掉。

(图:无水印版99美元解锁)

相信不少网友也已经想到去年曾经风靡一时的Deep Fake了。

Deep Fake是一个人工智能的换脸软件。自从第一次面世之后,它就被很多网友用来把AV小电影里面的女主角P成知名的明星…这个软件制造了不小的争议:很多人认为它是在侵犯女性隐私和名誉权,Deep Fake后来被国外各大平台封禁。

(图源:Wired)

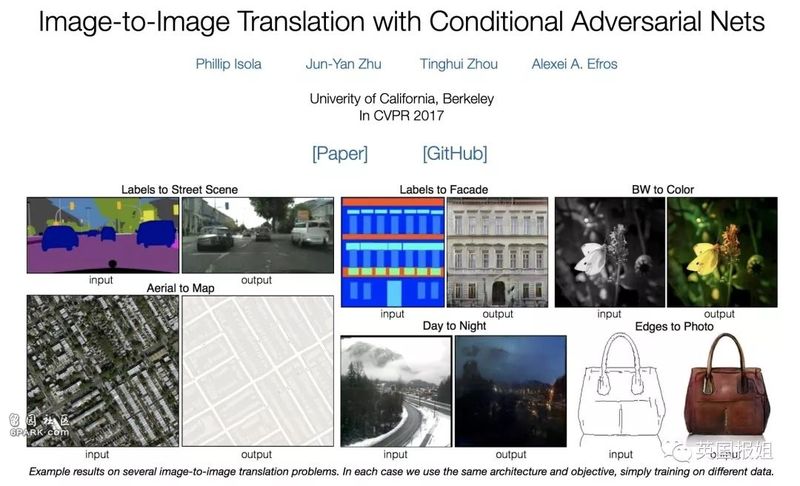

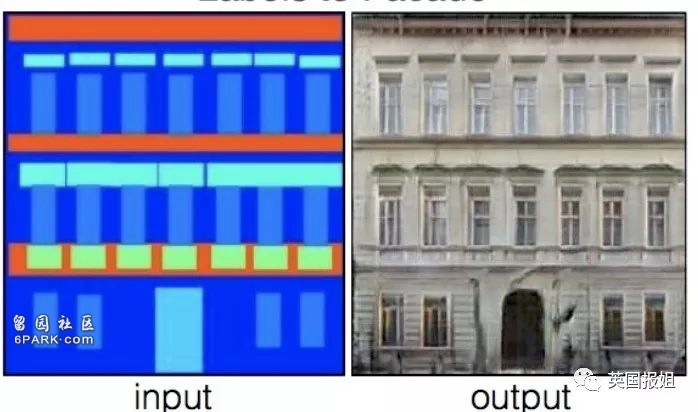

这一次的Deep Nude和Deep Fake一样,技术都是基于最早由UC伯克利大学提出的“图对图转换算法”。

(图源:UC Berkeley)

这项技术无疑是革命性的。它可以训练AI去把一张图片“翻译”成另一张相似,但又有所不同的图片。

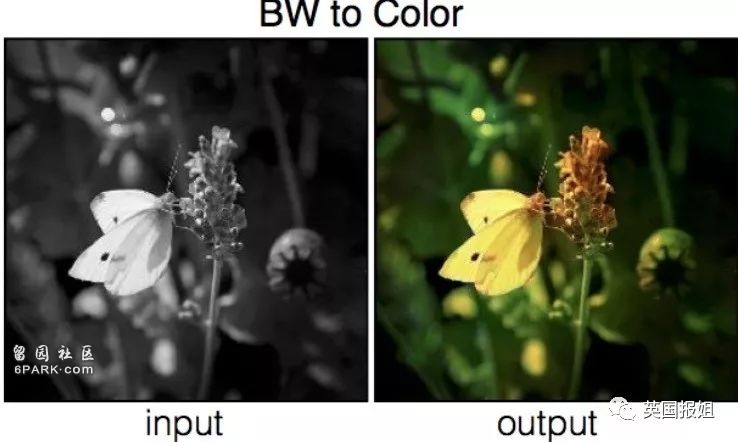

最简单的是把黑白照片变成彩色照片。AI通过不断学习,已经知道了自然中昆虫、植物的颜色,所以可以自动把照片上色。

再厉害一点的,比如可以把手提包设计草稿直接转换成实物的样子。算法自动帮你生成手提包的细节和质感▼

再进一步,只要你随手画几个长方形,算法就能帮你按照设计做成建筑物▼

当然,可以预见到的,当这项技术第一次面世之后,网友们很自然地想到了:可以用它做av啊。换脸工具Deep Fake很快就诞生了。

Deep Fake在换脸上的确比先前其他软件厉害得多,但它依然属于“专业级别”的软件范畴。也就是说,要使用Deep Fake换脸,你必须本人多多少少知道一点电影特效技术,需要有专业级别的视频处理硬件,以及好几小时乃至几天的处理时间才可以进行。这就导致了Deep Fake的使用者一直都只有很少一部分人。

(图:演员被Deep Fake做成川普的样子)

而这一次的Deep Nude和Deep Fake 不同的是,它的简单易用:任何人只要有电脑就可以使用,不需要昂贵的显卡或者处理器。处理时间也很快,毕竟生成照片比生成视频容易多了。花几分钟时间,自己同事的裸照就制作完成了。

(图源:Business Insider)

这种简便、易用的特点,让Deep Nude成为了比AV变脸更可怕的存在:想象一下,自己什么都没有做,突然之间同事或者朋友就开始传看自己的裸照。

虽然理论上来说,这些裸照中的身体并不是自己的。但正所谓造谣一张嘴辟谣跑断腿,辟谣的速度永远赶不上谎言传播的速度…

到最后,当所有人都会觉得他们已经把你看光,受害者的那一点解释又能算什么呢?

而且,这个app只能做女性的裸照。

根据别的媒体测试,如果你导入一张男生穿着内裤的照片,输出的就是一个没有生殖器的裸男。

按照制作者的解释:他也想做男版,但是网络上女性的裸照比男性多。而制作这个软件所涉及到的AI机器学习,是需要越多素材越好。所以目前只做出了女版。

嗯,虽然原因听起来有那么些合理,但结果依然没有变化:任何有心人都可以利用这个软件去散播污蔑某位女性,或者侵犯她隐私的照片。

用这个软件生成裸照,再用原谅宝识别。

真正做到了对女性一键就能荡妇羞辱。

制作者面对媒体采访时说:他并不是一个偷窥狂,他只是一个热爱技术的人。他的动机来源于他对AI的热情和好奇。

当然,这个软件还可以赚钱。经济上的利益也是驱动他进行发明的原因之一。

面对一些舆论的指责,制作者把他的产品和PS做了对比:他的软件所能做到的,PS早就可以做到了。任何人都可以通过图片处理软件画出任何人的裸照。而他所做的,只是加快了这个速度而已。

报姐在这里就不以最坏的情况去揣摩作者的动机。即便他是一个脱离了低级趣味的人,即便他的动机只是为了赚钱。

但他的产品本身,毫无疑问是在给坏人制造凶器,而且还是白送…

幸运的是,这个软件在受到媒体关注之后,制作者很快把它下了架。

他在推特上解释说:

几个月前,这个软件被制作了出来,它本来的用途只是娱乐而已。我们本以为这个软件每个月可能只有几个销量,所以一切都还可控。说实话,这个软件真的也不算好,它只能处理一些特定类型的照片(泳装照)。我们从未想过它会如此流行,如此不可控。我们低估了市场的需求。

尽管我们采取了一些安全措施(加水印),但是人们用它做坏事的可能性实在太高了。我们不希望用这种方式去赚钱。Deep Nude这个软件可能在网上删除不了了,但我们不想通过它来盈利。任何人从其他地方去下载或分享这个软件都是违约的。从现在开始Deep Nude不会再出任何新的版本。

还没升级的用户可以得到退钱。

这个世界还没准备好Deep Nude的出现。

报姐一直忘不掉作者的最后一句话“这个世界还没准备好Deep Nude的出现。”

曾经我们觉得,写成文字的东西就是真相。

到了19世纪,书本走进了千家万户,所有人都可以写作。但那时我们觉得,幸好还有照片,有图就有真相。

再后来,有了Photoshop,专业人员可以做出以假乱真的照片。但那时我们还庆幸:至少视频是真的。

但2010年以后,电影特效技术不断发展,再加上Deep Fake的出现,打破了这个信仰。

现在,任何东西都可能是假的,任何图片、视频都可能被有心人制作出来,去伤害别人。而我们却依然没有有效的法律或技术上的武器去制衡他们。

(图:《速度与激情》中用完全由特效制作的保罗沃克)

单单依靠舆论去让某个软件下架,是完全不够的。

想一下:制作Deep Nude的并不是什么互联网巨头,也不是什么牛逼的天才。他只是一个“热情”的程序员而已。如果他可以做到,那么说明这个技术,并没有我们想象的那么难。

就像那个制作者先前说过的:“技术一直都在,如果有人想要做坏事,用不用我的产品其实没什么差别。如果我不做,其他任何人一年内都可以把它做出来。”

(图源:CG Meetup)

你可以禁止软件,但技术,是永远也禁止不了的。

Deep Nude和Deep Fake背后的那个图片翻译算法,已经是很多家汽车公司自动驾驶技术的根源。往远了说,它在设计、艺术、修复老照片、等方面有着不可限量的用途。

就算是Deep Fake这个原本被用来做明星AV的软件,现在已经被很多电影公司利用了起来:它比现存的真人模拟特效技术都要便宜、好用。在接下来,很多电影将用这个技术来对演员妆容进行后期、让已经去世的演员在电影中出场…

(图:网友制作的汤姆克鲁斯Deep Fake)

在这样的大环境下,禁止一个程序是不可能阻止技术发展的。就算这个软件被禁止了,过几年还会有别的可能是其他用途的软件可以进行这个功能。

在不久的将来,可能人人都将会有随意更改照片或者视频的能力。当然,技术是不分性别的,不论男女都会受到相似的攻击。

希望在那个未来到来之前,法律法规和人们的道德制衡,能跟上技术的脚步。要不然,我们面对的,可能是一个没有隐私的未来。

不管这个世界有没有准备好,Deep Nude都将到来。

source:

https://

https://www.theverge.com/2019/6/27/18760896/deepfake-nude-ai-app-women-deepnude-non-consensual-pornography

https://www.vice.com/en_us/article/xwvz9a/watch-an-algorithm-turn-winter-into-summer-in-any-video-image-to-image-translation